ABOUT CHIMSEN

关于城信

致力成为最受客户信赖的一体化工程解决方案提供商

城信科技股份有限公司成立于2006年,注册资金6800万,总部设在深圳;是行业首批国家高新技术及专精特新企业,深圳市建筑工务署电子与智能化分类分级A+排名第一,拥有智能化设计甲级、电子与智能化专业承包一级、建筑机电专业承包一级、音视频甲级等资质。

了解详情

2006

成立于

500+

服务客户

6800万

注册资金

A+

深圳工务署智能化分级排名

MAIN BUSINESS

主营业务

坚持以客户为中心的服务理念,专注于智能化、信息化、数据/算力中心建设、舞台工艺、机电及洁净工程等领域整体解决方案的咨询、设计、交付的全程化服务。

Core Advantages

核心优势

高标准的交付履约体系

直接履约,全自营,不转包

自上而下贯彻的高标准质量要求和服务响应机制

独立的质量、安全检查监导团队

内部孵化、可靠的劳务合作伙伴

雄厚的人才团队

公司人才团队300+

一级建造师40+

中高级工程师70+

工程技术人员占比80%+

精细化的项目管理

独立的质量、安全、成本管理团队

团队考核及激励与质量、客户满意度挂钩

专用的工程项目ERP等信息化管理工具提升管理效率

丰富的经验沉淀

18年专注核心业务领域

近500+精品交付案例

供应链合作体系

统一的施工工艺标准

自建技术培训中心,并统一高标准的工艺工法

多年的施工工艺标准的优化和积累

直观、明确的工艺实施指导方案及验收标准

专业的集成研发能力

自有定制化开发团队

近15年信息化集成经验

自研集成管理平台

Cases

成功案列

智慧教育

智慧医疗

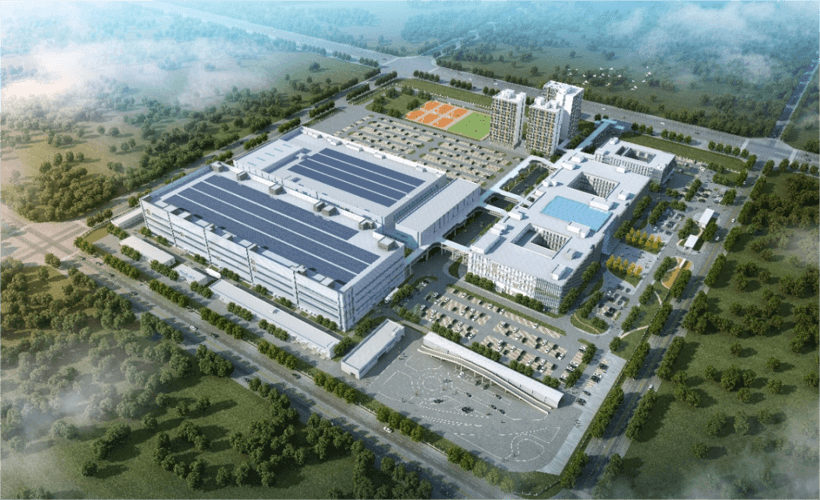

智慧园区

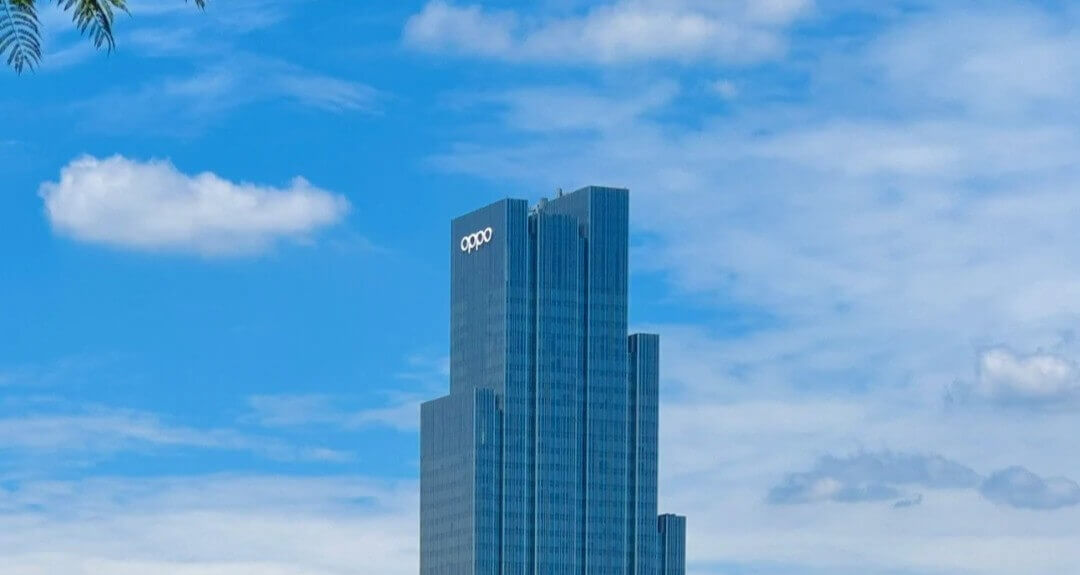

智慧大厦

智慧办公

智慧文体

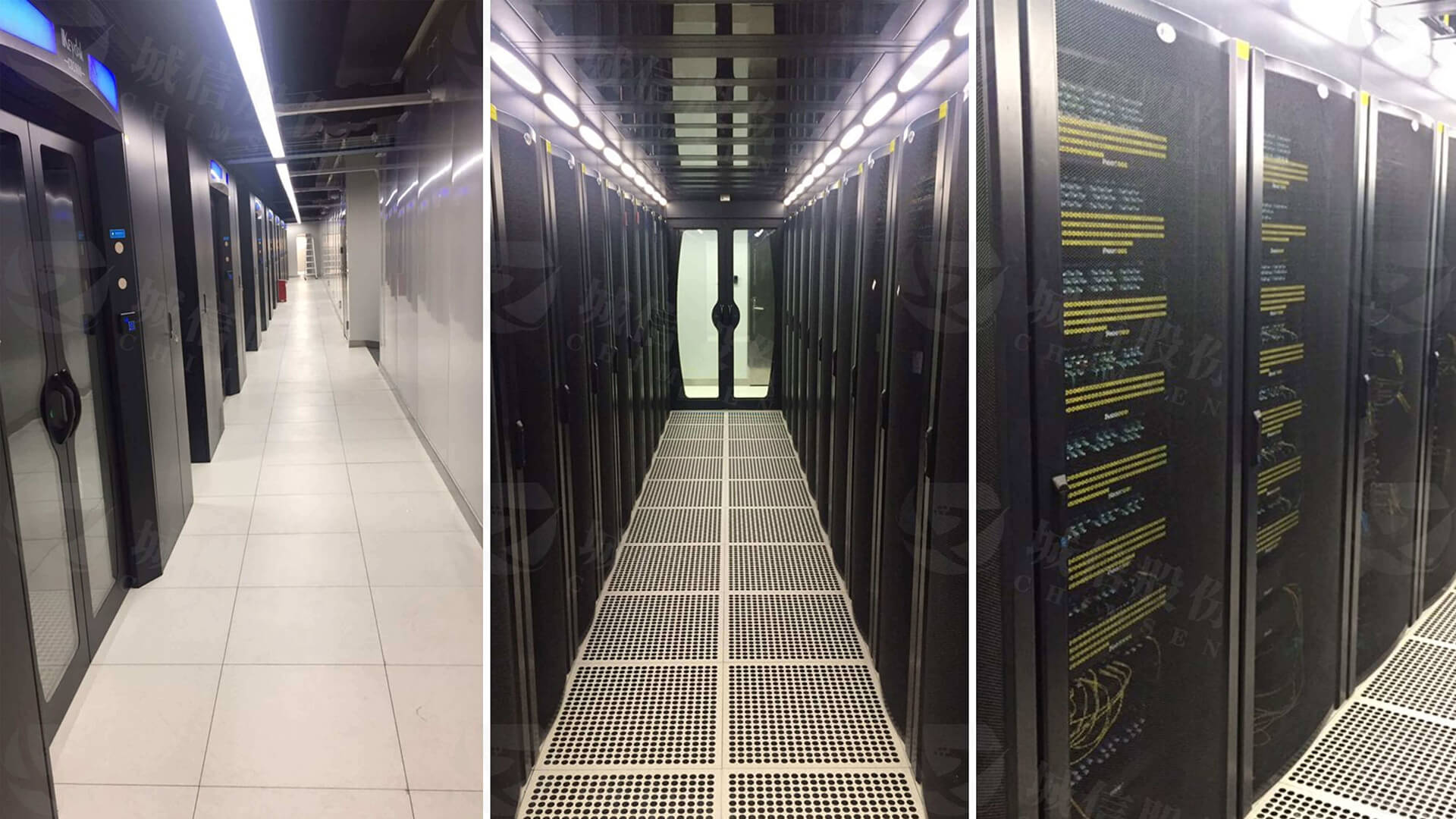

数据中心

信息集成

净化工程

机电工程